Há um problema bem sério quando a maioria das pessoas pensa nas alucinações de IA: achar que elas são inevitáveis.

Isso não é nem de longe verdade. A IA alucina e vai continuar alucinando, mas em muitos casos isso é resultado das escolhas que usuários fazem ao configurar prompts.

Clarificando: não é que o prompt seja a maior causa dos erros nas respostas. Mas é necessário entender que o prompt correto tem medidas de segurança para evitar as alucinações de IA.

Ser claro e ter medidas de segurança prontas contra as alucinações é fundamental para operar a IA. É uma limitação da máquina. Pense no Photoshop: ele consegue manipular qualquer imagem, mas com as limitações do hardware.

Experimente usar o Photoshop com 8GB de RAM no seu computador. Não vai dar muito certo. Com a IA, nós, os usuários criando os prompts, somos o hardware.

Hoje vamos conversar melhor sobre a natureza das alucinações de IA e como combatê-las. Vamos juntos?

Desmistificando a figura do engenheiro de prompts

Um ponto precisa ser deixado bem claro quando falamos sobre IA: a idéia do engenheiro de prompts não é o que a maioria das pessoas pensa.

No LinkedIn mesmo você vai encontrar várias pessoas que não só se intitulam engenheiros de prompts, como também dizem ter um conhecimento extra, capaz de desbancar até especialistas de qualquer área ao trabalhar com a IA.

Uma pergunta honesta, sem julgamentos: ao usar a IA para falar sobre processos de marketing, quem é melhor: o especialista em marketing ou um engenheiro de prompts?

Essa é a pergunta que vai permear todo esse texto. Não há resposta definida, porque cada especialista e cada engenheiro de prompts é um indivíduo diferente. Cada um tem suas forças e fraquezas.

Mas vamos fazer um argumento a favor dos especialistas por aqui, e exigindo dos engenheiros de prompts um compromisso extra — a necessidade de pesquisar, estudar e conhecer a área para a qual eles querem escrever.

É como pensar em um redator publicitário e um especialista em determinado assunto. O especialista tem muito mais conhecimento da sua área, mas o redator é quem consegue transformar esse conhecimento em copys vendedoras e de alta performance.

Dessa forma, engenheiros de promtp vão conseguir bons resultados com a IA, mas apenas com muita pesquisa na área.

E em contrapartida, especialistas nas suas áreas também conseguem bons resultados, mas sabendo como explorar a engenharia de prompts.

Mas como isso acontece? Entender sobre um determinado assunto exige pesquisa, e pesquisas são simples de entender — elas podem ser feitas até pela própria IA.

Mas como um especialista específico consegue usar a IA da melhor forma possível? Como ele consegue “aprender” a engenharia de prompts?

Nos próximos tópicos vamos conversar melhor sobre isso. Acompanhe:

A fluência da IA engana engenheiros de prompts, mas não convence especialistas

Um dos pontos principais que especialistas em suas áreas precisam entender sobre a IA é que ela sempre vai priorizar a fluência.

A IA busca entregar os resultados mais elaborados que ela conseguir. Mesmo se você criar regras — “faça 300 palavras”, por exemplo — essas 300 palavras ainda vão priorizar a fluência das informações e a cadência do texto.

Um exemplo rápido: pedindo uma receita para a IA com um prompt muito simples, sua principal preocupação é a forma com que a receita é entregue.

A IA vai buscar entregar um texto que se assemelha aos modelos de receita que ela tem nos seus bancos de dados. O importante para ela, aqui, é acertar esse modelo. As informações específicas são sua segunda preocupação.

É por isso que a IA alucina. Buscando se adequar às referências que ela usa para montar sua resposta, infelizmente os fatos acabam ficando em segundo plano.

Então não é que a IA está necessariamente “alucinando”. É que a sua construção prioriza a fluência.

Mas como resolver essa situação, então? Aplicando condicionantes. Veja mais logo abaixo:

O que a OpenAI diz sobre alucinações

Isso que conversamos até agora não é novidade nem achismo. A própria OpenAI, no seu artigo Why language models hallucinate?, diz exatamente a mesma coisa:

Os modelos de linguagem aprendem primeiro por meio do pré-treinamento, um processo que prevê a probabilidade da próxima palavra e tem como base imensas quantidades de textos. Diferentemente dos problemas tradicionais de aprendizado de máquina, as afirmações não são rotuladas como verdadeiras ou falsas. O modelo simplesmente acessa exemplos positivos de linguagem fluente e faz aproximações das distribuições mais comuns.

A IA busca replicar a fluência através da adivinhação das próximas palavras, em um modelo probabilístico conhecido como estocástico.

É o mesmo modelo do autocomplete em smartphones.

Ainda assim, o que diferencia os LLMs desses modelos mais simples é a capacidade que nós temos, como usuários, de analisar as respostas e fornecer mais esclarecimentos.

É justamente esse ponto que os engenheiros de prompts precisam entender. E é aí que os especialistas brilham.

Mais sobre isso no próximo tópico:

Condicionantes são necessários para o bom uso da IA

Para lidar com os problemas da preferência pela fluência que as IAs têm, é necessário pensar em condicionantes básicos.

Ser muito vago nos seus prompts é problemático, mas ser muito específico apenas uma vez também.

Quando você pede para a IA criar “um texto sobre marketing direto”, ela vai priorizar a fluência, e não os fatos.

Mas da mesma forma, se você criar condicionantes apenas no primeiro prompt e não prosseguir na conversa, os erros ainda vão existir.

A ideia é tratar a IA como um diálogo. Os condicionantes precisam ser adicionados ao longo de vários prompts.

Esses condicionantes precisam ser pensados de antemão, e devem ser parte de um briefing de IA, que é diferente de um briefing para humanos.

Vamos conversar sobre isso logo abaixo. Acompanhe:

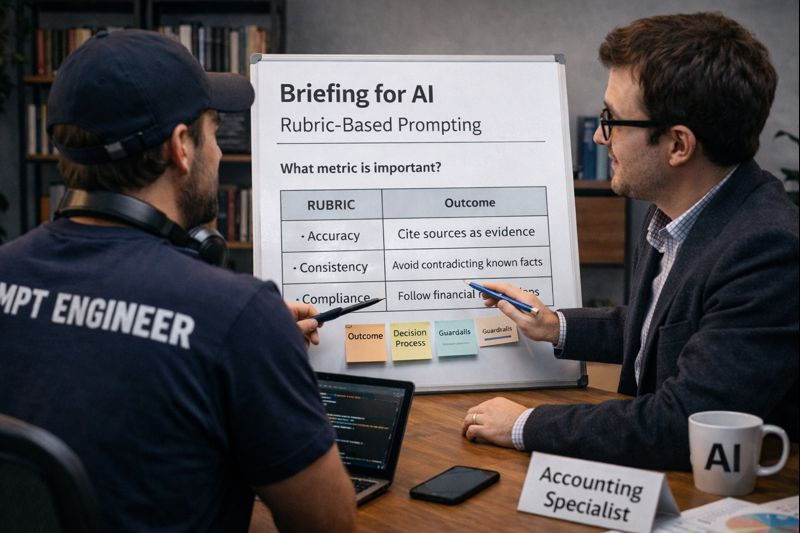

Criando um briefing de IA com base em rubricas — um framework de critérios

Um texto recente da Search Engine Land defende a criação de rubricas quase acadêmicas para criar prompts melhores e ter resultados melhores, sem alucinações, com a IA.

Esse sistema de rubricas é praticamente um framework de critérios que buscam avaliar cada resultado da IA. É um conceito acadêmico, que busca, na prática, avaliar os resultados como professores avaliam provas.

Ou seja, é um sistema de governança que estabelece critérios prévios para evitar as alucinações tão comuns em sistemas de IA. Você determina como a avaliação deve ser feita previamente, e depois do resultado pronto, pode usá-la para fazer correções.

Veja um exemplo na tabela abaixo de um framework de rubrica:

As ações que inserimos aqui são exemplos, mas exemplos baseados nas próprias recomendações da OpenAI — pedir esclarecimentos, recusar extrapolação e suspender a resposta são recomendações importantes que muitas vezes não são seguidas.

Esse framework é simples, mas ele também é exigente. Você vai precisar, para cada resposta, colocá-lo em prática e analisar todos os pontos, pedindo refações a todo o momento.

Além disso, há a necessidade do processo ser conduzido por um especialista na área. Sem essa figura, não é possível garantir que os itens vão ser interpretados da melhor forma.

É por isso que dizemos que um engenheiro de prompts sem pesquisa não consegue produzir os melhores resultados na IA. É necessário dominar o assunto para entender se a IA está seguindo o escopo, sendo ambígua, etc.

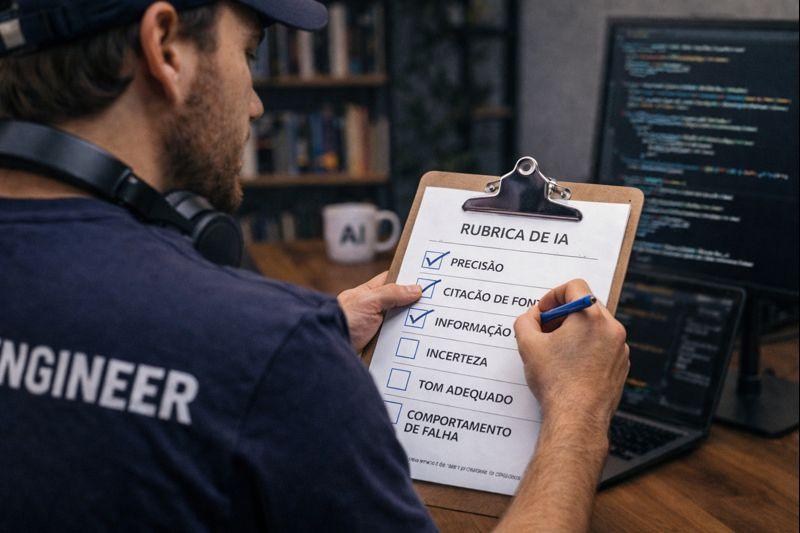

Como criar uma rubrica de IA?

Bom, nosso exemplo ali em cima começa a elaborar sobre a criação de uma rubrica de IA, mas é importante definir padrões claros de como criá-lo.

O que vamos oferecer aqui, no finalzinho do texto, são nossas sugestões, inspiradas pela rubrica de exemplo de Toby Bartlett, redatora do Search Engine Land.

Logo depois vamos conversar sobre dois métodos de implementação dessa rubrica — uma feita diretamente no prompt, outra feita separadamente, como parte do processo de revisão de conteúdo.

Você pode criar os critérios que quiser, mas Bartlett determina alguns para testarmos. Acompanhe:

- Requisitos de precisão: definição explícita do que precisa ser comprovado, do que é considerado evidência válida e se aproximações são ou não aceitáveis;

- Expectativas sobre fontes: orientações claras sobre a necessidade de citar fontes, se elas devem vir de materiais fornecidos ou como lidar com informações conflitantes;

- Tratamento da incerteza: instruções diretas sobre como o modelo deve agir quando a informação estiver ausente, ambígua ou incompleta;

- Restrições de confiança e tom: limites de linguagem para evitar que respostas especulativas sejam apresentadas como fatos;

- Comportamento em caso de falha: autorização e preferência por interromper, qualificar a resposta ou adiar a entrega, em vez de inferir ou “chutar”.

Mas como fazer a aplicação desses parâmetros? Há duas formas de pensar na rubrica de IA. Vamos conversar sobre elas logo abaixo:

.png)

Aplicando as rubricas de IA — duas abordagens

Segundo Bartlett, o uso de rubricas para evitar alucinações de IA deve ser feito dentro do próprio prompt.

Porém, isso elimina a função humana, e entrega todo o poder de checagem de volta à IA.

Ou seja, acaba sendo responsabilidade da IA gerar o material e, ao mesmo tempo, se policiar sobre a qualidade do material.

Porém, precisamos entender que isso também é uma forma de facilitar essa checagem e a aplicação da rubrica.

Se você abrir a tabela em outra aba e ir fazendo a revisão ponto por ponto, manualmente, também não vai ser nada simples. Será um trabalho longo e a velocidade que a IA traz para a produção de material pode ser até anulada.

Se você decidir ir pelo processo manual, o ideal é contar com uma pessoa específica para fazer a revisão, alguém que não seja o próprio redator do texto.

Isso acelera o trabalho ao adicioná-lo a um processo de produção de conteúdo.

Se você optar por usar a própria IA para fazer a revisão pós-rubrica, adicione os parâmetros logo depois do prompt.

Veja o exemplo que Bartlett ofereceu em um benchmark competitivo usando a IA:

- Analise por que o site do [concorrente] pode estar performando melhor que o nosso em relação a [tema]. Apresente insights e recomendações;

- Não afirme posições de ranking, volumes de tráfego ou recursos de SERP a menos que essas informações estejam explicitamente fornecidas no prompt.

- Caso dados necessários estejam ausentes, indique claramente o que não pode ser determinado e quais insumos adicionais seriam necessários.

- Quando as evidências forem incompletas, apresente recomendações de forma condicional, evitando linguagem definitiva sem sustentação.

- Se a análise não puder ser realizada com confiabilidade, forneça uma resposta parcial em vez de inferir ou supor resultados.”

- Não afirme posições de ranking, volumes de tráfego ou recursos de SERP a menos que essas informações estejam explicitamente fornecidas no prompt.

É simples assim.

O interessante é que essa rubrica pode ser aplicada hoje ainda. Faça o teste e deixe nos comentários quais suas impressões. Funciona? Não funciona? Como melhorar?

Vamos ficar esperando. Obrigado pela leitura e pela participação.

Posts recentes

Nosso blog tem conteúdos semanais feitos por especialistas

3 Tech Stacks de Marketing para conhecer e aplicar

Como qualificar um lead? Veja 5 estratégias funcionais (e simples)

Torne seu marketing digital mais estratégico

Agende uma conversa e receba o contato da nossa equipe. Temos um time de especialistas em desenvolver soluções e entregar resultados.